Der er en endeløs række grunde til, en person eller en virksomhed ønsker at bruge web crawler software. Denne type program søger på internettet i en udpeget måde, der kunne automatiseres, metodisk eller på en ordentlig måde. Hvis du er ny til begrebet web crawler software, måske du har hørt om edderkopper, bots, myrer, automatiske indekser, robotter eller scutters? De er alle stort set det samme!

Målet med Web Crawler Software

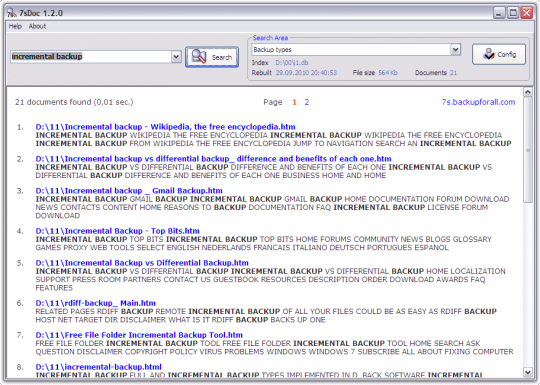

Når du tænker på web crawling software, du sandsynligvis forestille de store navn søgemaskiner som Google, Bing og Yahoo. Deres bots kravle gennem websider for at bestemme indhold, relevans og indeksering. Ved at skabe en kopi af besøgte sider, kan de give hurtigere og mere præcise søgninger. SqrBox vil fortælle dig, at du behøver bestemt ikke at være en søgemaskine til at have et behov for webcrawler software. Du er simpelthen nødt til at være nogen, der har behov for at indsamle store mængder eller ekstremt indviklet oplysninger.

Typer af Web Crawler Software

Hvis du planlægger at bruge de tjenester af en professionel virksomhed som SqrBox, behøver du ikke virkelig har brug for at beskæftige sig med alle de komplicerede lingo om webcrawler software. Alligevel er det nyttigt at forstå et par ting om det.

Fokuseret Crawling - Formålet med denne type web crawler software er at hente sider, der synes at indeholde tilsvarende oplysninger. Der er ofte nogle mangler, der er forbundet med denne metode selv og den faktiske udførelse af crawler og resultatet afhænger af, hvordan rige links er på det specifikke emne, der søges. Denne type webcrawler software anvendes ofte som udgangspunkt for at indsnævre søgninger efter yderligere gennemgang.

URL Normalisering - webcrawler software vil ofte udføre en vis grad af URL normalisering som hjælper med at reducere gentagne gennemgang af den samme kilde mere end én gang.

Begrænsning Fulgt Links - I nogle tilfælde kan webcrawler-software vil undgå visse webindhold og kun opsøge .html sider. For at gøre dette, bliver URL'en ofte undersøgt og derefter ressourcer vil kun blive anmodet om der er visse tegn i webadressen såsom .html, .asp, .htm, .php, .aspx, .jspx eller .jsp. webcrawler software vil typisk ignorere ressourcer med "?" . at undgå edderkop fælder

Krav :

.NET Framework 3.5

Kommentarer ikke fundet